La Inteligencia Artificial es parte cada vez más preponderante de nuestro día a día: ya sea fuente de consulta o como herramienta para optimizar cuestiones laborales y de estudio. Lo cierto es que un uso incorrecto o descuidado de la IA puede exponernos a riesgos innecesarios y peligrosos.

Ante este escenario, realizamos una encuesta en Latinoamérica de la que participaron más de 1.000 personas, para comprender sus hábitos de uso. En concreto, respondieron usuarios y usuarias de Venezuela, México, Colombia, Argentina, Perú, Guatemala, Chile, Ecuador, El Salvador, Uruguay, Panamá, Honduras, Costa Rica, Nicaragua, Bolivia, República Dominicana y Paraguay.

¿Una de las conclusiones más importantes? El 80% de los encuestados usa la IA, pero más de la mitad no chequea la información obtenida. A continuación, expondremos los principales resultados obtenidos, como también qué aprendizaje se puede obtener respecto de las medidas de seguridad que implementan las personas para preservar sus datos y privacidad, cuando utilizan la Inteligencia Artificial.

Se usa mucho, pero se chequea poco

Uno de los datos obtenidos de la encuesta es que el 80% indicó usar la IA (45% lo hace frecuentemente, y 35% ocasionalmente). Ahora bien, las alarmas se encienden si se tiene en cuenta que el 55% no chequea siempre la información obtenida. ¿El detalle? El 14% no lo hace nunca, y el 39% lo hace solamente a veces. Y esto puede ser muy riesgoso.

¿Por qué? Si bien es cierto que los modelos de IA pueden entregar información certera, no están exentos de generar respuestas incorrectas o sesgadas. Por eso, para garantizar la seguridad (y más en temáticas sensibles como las vinculadas a lo legal, las finanzas o la salud) siempre es aconsejable contrastar la información obtenida con fuentes oficiales.

Y aún hay más: los modelos de IA pueden ser vulnerables a ataques en los que un usuario malintencionado introduce comandos engañosos mediante técnicas como prompt injection para manipular las respuestas. Así, un ciberatacante podría inducir a la IA a responder brindando instrucciones erróneas o proporcionar información falsa.

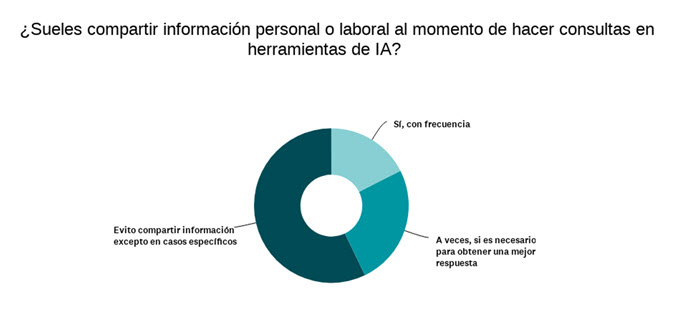

Datos personales: el gran descuido

Otro punto a tener en cuenta es que el 40% afirmó compartir con frecuencia o esporádicamente información personal y laboral con la Inteligencia Artificial (el 17% siempre, y el 25% a veces). Lo que preocupa aún más es que casi el 60% no lee las políticas de privacidad y que solo la mitad de las personas toma una medida concreta para proteger su información.

En principio, es aconsejable evitar compartir datos personales y sensibles. Por ejemplo, no ingresar proactivamente información personal, como por ejemplo contraseñas o datos bancarios, en cualquier chat de IA. ¿El motivo? Estas herramientas pueden procesar dicha información e incluso utilizarla para entrenar futuros modelos, por lo cual es necesario minimizar el riesgo de que esos datos se almacenen y se expongan en el futuro.

Además de no compartir información personal y laboral en este tipo de herramientas, es muy importante tomar conocimiento de todas las configuraciones de privacidad para entender qué tipo de datos se almacenan, si se comparten con terceros y cómo pueden ser utilizados en el futuro. ¿Un tip? Revisar periódicamente términos y políticas de la aplicación, por cualquier nueva opción de seguridad y privacidad que esté disponible.

El futuro y la IA: optimismo y preocupación

De cara al futuro, la Inteligencia Artificial es vista con muy buenos ojos por la mayoría de los encuestados: 80% la ve como algo positivo. Pero atención, porque un 43% cree que la IA será útil en los próximos años, pero con riesgos asociados. Entre las principales preocupaciones vinculadas al uso de la IA, esto fue lo que respondieron:

- 65%: fraudes y estafas

- 47%: deepfakes y fakenews

- 45%: falta de privacidad y recopilación de datos

Respecto del primer punto (fraudes y estafas), no es una novedad que el cibercrimen ha encontrado en la Inteligencia Artificial una herramienta más que potente para llevar sus estafas y fraudes a otro nivel. De hecho, aumentó el número de correos de phishing, dado que la IA generativa genera contenidos cada vez más convincentes para que las víctimas revelen información sensible u obtener algún rédito económico. Pero no es todo…

Las estafas por audio también se han perfeccionado, al punto que se necesitan tan solo unos pocos segundos de la voz de una persona para producir algo peligrosamente real.

En cuanto a las deepfakes y fakenews, hay un dato del MIT que avala esta preocupación: las noticias falsas tenían un 70% de probabilidad más de ser compartidas que las noticias reales. Si bien el estudio tiene ya algunos años, basta con pasar algunas horas en redes sociales y foros para suponer que ese número sigue siendo válido.

De hecho, los ciberdelincuentes también utilizan la información fabricada como una herramienta. Hay sitios web que aparentan ser medios legítimos y publican artículos diseñados para generar alarma. ¿El objetivo? Redirigir a los usuarios a páginas maliciosas. Este tipo de phishing combina desinformación con tácticas de ingeniería social, creando escenarios convincentes que facilitan el fraude digital.

Respecto del último punto (privacidad y recopilación de datos), remarcamos lo apuntado anteriormente: es clave entender qué tipo de datos almacena la herramienta utilizada, si luego se comparte con terceros y de qué manera será usada esa información en el futuro.

Pensamientos finales

El análisis de los resultados obtenidos en la encuesta permite confirmar que si bien hay una gran adopción de los usuarios y usuarias respecto de la Inteligencia Artificial, aún queda mucho camino por recorrer en cuanto a los hábitos responsables y seguros de la misma. La falta de chequeo de la información, el poco cuidado al compartir datos sensibles y el desinterés en las políticas de privacidad son alarmas que deben ser escuchadas.

Como siempre en estos casos, la solución no está en temerle la herramienta o dejar de usarla, sino en incorporar acciones concretas, para utilizarla de manera segura y crítica. En este escenario, entonces, el desafío es llevar a cabo un uso más consciente de la IA.