Autrefois confinée aux laboratoires de recherche, l'intelligence artificielle générative est désormais accessible à tous, y compris aux personnes malintentionnées qui utilisent ces outils non pas pour stimuler la créativité, mais pour alimenter la tromperie. La technologie deepfake, capable de créer des vidéos, images et fichiers audio d'un réalisme saisissant, devient de plus en plus prisée non seulement pour imiter des célébrités ou influencer l'opinion publique, mais aussi pour commettre des vols d'identité et toutes sortes d'escroqueries.

Sur les plateformes de réseaux sociaux comme TikTok et Instagram, la portée des deepfakes, ainsi que leur potentiel de nuisance, peut être particulièrement stupéfiante. Des chercheurs d'ESET en Amérique latine ont récemment découvert une campagne sur TikTok et Instagram où des avatars générés par IA se faisaient passer pour des gynécologues, diététiciens et autres professionnels de santé afin de promouvoir des compléments alimentaires et produits de bien-être. Ces vidéos, souvent très soignées et convaincantes, déguisent des arguments de vente en conseils médicaux, trompant les personnes crédules pour les pousser à des achats douteux et potentiellement dangereux.

Anatomie d'une tromperie

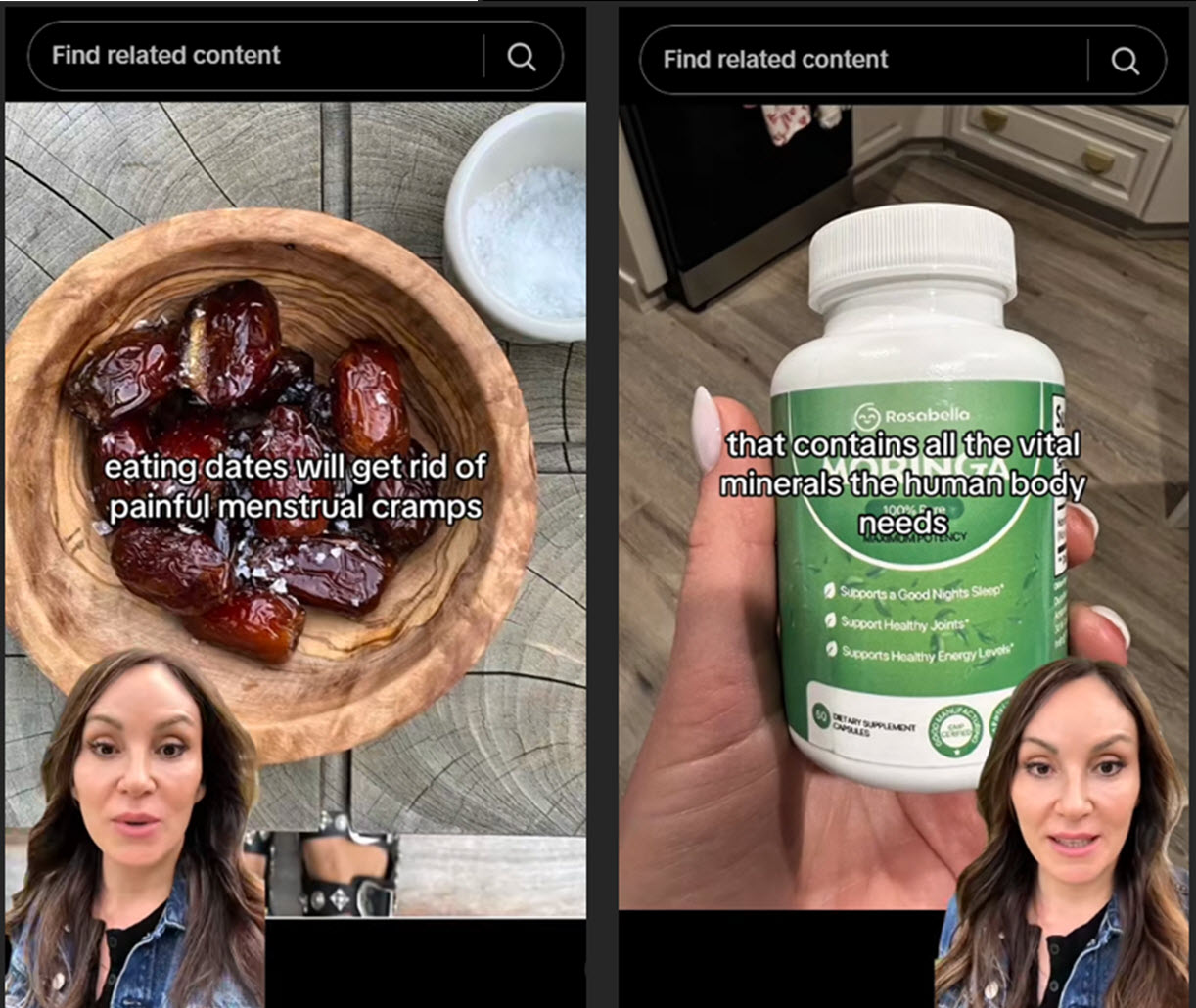

Chaque vidéo suit un scénario similaire : un avatar parlant, souvent niché dans un coin de l'écran, dispense des conseils santé ou beauté. Délivrés avec un air d'autorité, ces conseils mettent fortement l'accent sur les remèdes « naturels », orientant subtilement les spectateurs vers des produits spécifiques en vente. En exposant leurs arguments commerciaux sous l'apparence de recommandations d'experts, ces deepfakes exploitent la confiance accordée à la profession médicale pour stimuler les ventes, une tactique aussi contraire à l'éthique qu'efficace.

Dans un cas particulier, le « médecin » vante un « extrait naturel » comme alternative supérieure à l'Ozempic, ce médicament célèbre pour son aide à la perte de poids. La vidéo promet des résultats spectaculaires et vous dirige vers une page Amazon, où le produit est décrit comme des « gouttes relaxantes » ou des « aides anti-gonflements », sans aucun lien avec les bienfaits vantés.

D'autres vidéos élèvent encore les enjeux, promouvant des médicaments non approuvés ou de faux remèdes contre des maladies graves, parfois même en détournant l'apparence de vrais médecins reconnus..

L'IA à la « rescousse »

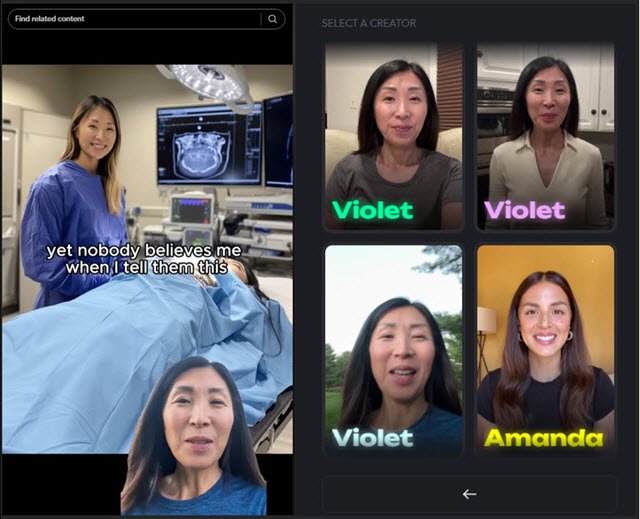

Ces vidéos sont créées avec des outils d'IA légitimes qui permettent à quiconque de soumettre de courtes séquences et de les transformer en avatar sophistiqué. Bien que cela représente un avantage pour les influenceurs cherchant à multiplier leur production, cette même technologie peut être détournée pour propager des affirmations trompeuses et de la désinformation – en d'autres termes, ce qui peut fonctionner comme un gadget marketing se transforme rapidement en mécanisme de diffusion de mensonges.

Nous avons repéré plus de 20 comptes TikTok et Instagram utilisant de faux médecins deepfake pour promouvoir leurs produits. L'un d'eux, se faisant passer pour une gynécologue forte de 13 années d'expérience, a été directement retracé jusqu'à la bibliothèque d'avatars de l'application. Bien qu'un tel détournement viole les conditions d'utilisation des outils d'IA courants, cela souligne également la facilité avec laquelle ils peuvent être utilisés à des fins malveillantes..

Au final, il ne s'agit peut-être pas « seulement » de compléments alimentaires sans valeur. Les conséquences peuvent être plus graves, car ces deepfakes peuvent éroder la confiance dans les conseils de santé en ligne, promouvoir des « remèdes » nocifs et retarder un traitement approprié.

Tenir les faux médecins à distance

À mesure que l'IA devient plus accessible, repérer ces contrefaçons devient plus délicat, posant un défi plus large même pour les personnes expertes en technologie. Cela dit, voici quelques signes qui peuvent vous aider à identifier les vidéos deepfake :

- Des mouvements de lèvres désynchronisés qui ne correspondent pas à l'audio ou des expressions faciales qui semblent rigides et artificielles

- Des défauts visuels, comme des contours flous ou des changements soudains d'éclairage, trahissent aussi souvent la supercherie

- Une voix robotique ou excessivement policée constitue un autre signal d'alarme

- Vérifiez également le compte lui-même : les nouveaux profils avec peu d'abonnés ou sans historique éveillent les soupçons

- Méfiez-vous des affirmations hyperboliques, comme « remèdes miracles », « résultats garantis » et « les médecins détestent cette astuce », surtout si elles manquent de sources crédibles

- Vérifiez toujours les affirmations auprès de ressources médicales fiables, évitez de partager des vidéos suspectes, et signalez les contenus trompeurs à la plateforme

À mesure que les outils d'IA continuent de progresser, distinguer entre contenu authentique et fabriqué deviendra plus difficile plutôt que plus facile. Cette menace souligne l'importance de développer à la fois des garde-fous technologiques et d'améliorer notre littératie numérique collective qui nous aidera à nous protéger de la désinformation et des escroqueries susceptibles d'impacter notre santé et notre bien-être financier.