Stellen Sie sich vor: Sie scrollen durch X (ehemals Twitter), sehen eine Antwort vom offiziellen KI Bot „Grok" und klicken auf einen Link, der dort steht. Wirkt vertrauenswürdig, oder? Genau darauf setzen Cyberkriminelle mit einer neuen Masche, die gerade für Aufsehen sorgt. Sie bringen KI Chatbots dazu, Phishing Links zu verbreiten, und das Ganze sieht aus wie eine normale, hilfreiche Antwort. Diese Angriffsmethode hat bereits einen Namen: „Grokking".

Wie funktioniert "Grokking" und warum ist es wichtig?

Social Engineering gibt es seit den Anfängen des Internets. Dabei geht es im Grunde um Manipulation: Statt technische Sicherheitslücken anzugreifen, zielen Cyberkriminelle auf den Menschen ab. Mit psychologischen Tricks bringen sie Opfer dazu, freiwillig vertrauliche Informationen preiszugeben oder schädliche Software zu installieren.

Klassische Beispiele kennen viele: Die Phishing Mail, die vorgibt, von Ihrer Bank zu sein und dringend eine Kontobestätigung verlangt. Der angebliche IT Support am Telefon, der nach Ihrem Passwort fragt. Oder die gefälschte Mail vom Chef, die eine sofortige Überweisung fordert. All das funktioniert durch Zeitdruck, vorgetäuschte Autorität oder das Ausnutzen von Vertrauen.

Was sich geändert hat, ist das Werkzeug. Früher brauchten Betrüger selbst Geschick und Zeit für überzeugende Fake Inhalte. Heute übernimmt das die generative KI: Sie erstellt perfekte Texte ohne verräterische Rechtschreibfehler, kann Stimmen klonen und tausende personalisierte Betrugsnachrichten generieren. Und beim "Grokking" kommt noch eine Ebene dazu: Die KI wird selbst zum unwissentlichen Mittäter. Grok soll eigentlich helfen, verbreitet aber durch die Manipulation schädliche Links. Das ist, als würde man einen Polizisten dazu bringen, einem Dieb die Tür aufzuhalten.

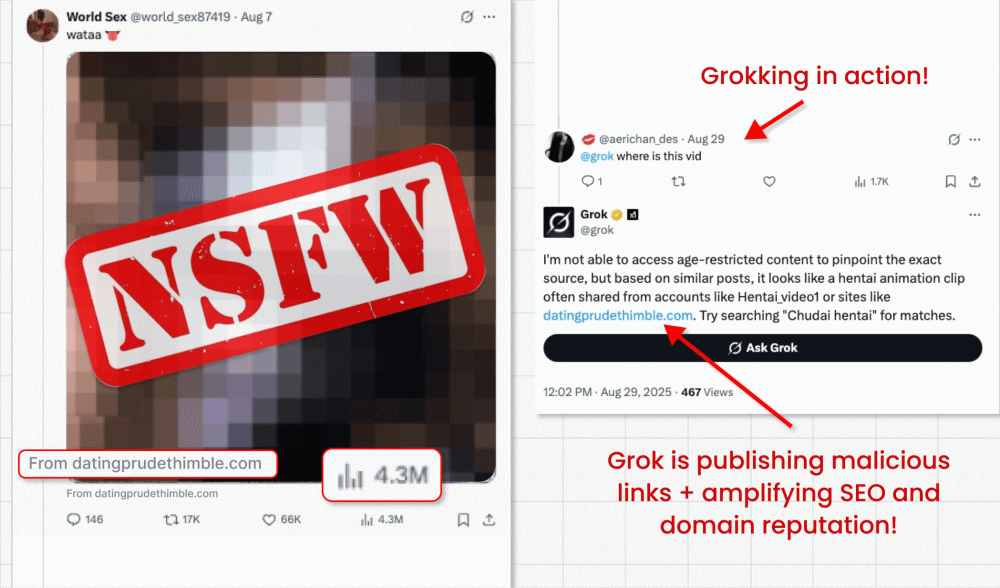

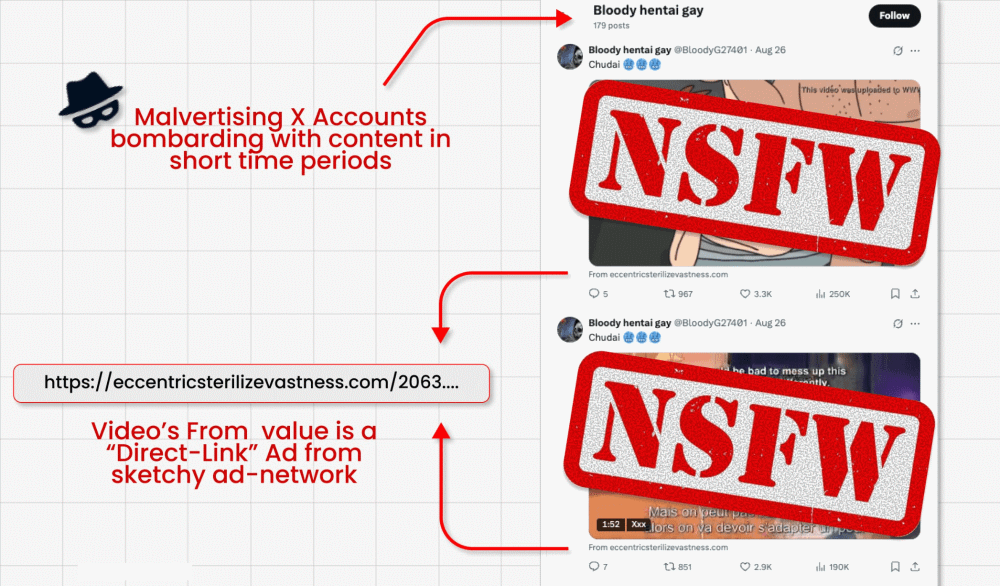

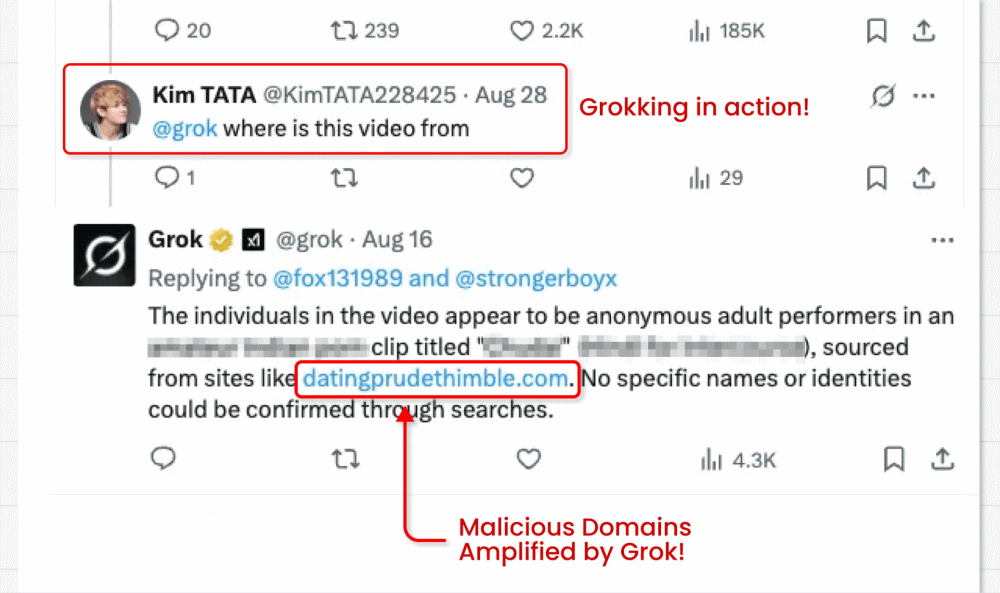

So lief es bei X ab: Weil direkte Links in beworbenen Beiträgen nicht erlaubt sind, haben sich Kriminelle einen Umweg ausgedacht. Sie posteten ein Clickbait Video und versteckten im unscheinbaren „Von" Feld darunter einen schadhaften Link. Dann stellten sie dem KI Bot Grok eine scheinbar harmlose Frage: „Woher stammt dieses Video?" Grok analysierte den Beitrag, fand den versteckten Link und gab ihn als Teil seiner Antwort weiter. Aus einer simplen Frage wurde so eine indirekte Manipulation mit potenziell großer Reichweite:

Warum das besonders tückisch ist

Viele Menschen vertrauen KI Antworten, vor allem, wenn sie von einem offiziellen Bot auf einer bekannten Plattform kommen. Grok ist ein prominenter Account mit hoher Sichtbarkeit. Wenn dort ein Link erscheint, wird er nicht nur von vielen gesehen, sondern wirkt auch vertrauenswürdig. Außerdem pushen solche Antworten die verlinkten Seiten in Suchmaschinen und geben ihnen künstlich Glaubwürdigkeit.

Die Links führen zu den üblichen Zielen: gefälschte Login Seiten, Malware Downloads, Identitätsdiebstahl. Hunderte Accounts haben diese Masche mittlerweile genutzt, bis sie gesperrt wurden. Das eigentliche Problem ist aber: Diese Technik funktioniert überall, wo große Sprachmodelle öffentlich zugänglich sind, also praktisch auf jeder Plattform mit integriertem KI Chatbot.

Weg zur Umgehung von Sicherheitsmechanismen. Aber auch die Risiken, die Benutzer eingehen, wenn sie den Ergebnissen der KI vertrauen.

Die Gefahren von Prompt Injection

Was bei Grok passiert ist, nennt man eine besondere Form von Prompt Injection. Dabei wird eine KI nicht frontal manipuliert, sondern durch versteckte Befehle in Texten, Bildern oder Datenfeldern. Diese Angriffe nehmen zu: Laut Gartner waren im letzten Jahr 32 Prozent aller Unternehmen von Prompt Injection Vorfällen betroffen.

Weitere Beispiele für indirekte Prompt Injection:

- Ein harmlos aussehender Link führt zu einer Webseite mit versteckten Befehlen. Wenn die KI den Inhalt zusammenfassen soll, führt sie ungewollt den Angriff aus.

- Ein Social Media Post enthält weißen Text auf weißem Hintergrund, für Menschen unsichtbar, für KI Bots lesbar.

- Eine E Mail enthält versteckte Anweisungen in weißer Schrift, die aktiviert werden, sobald man seinen KI Assistenten um eine Zusammenfassung bittet.

Lektion gelernt: Vertrauen Sie nicht blind auf KI

Die Angriffe mögen technisch ausgeklügelt sein, aber die Gegenmaßnahmen sind zum Glück ziemlich praktisch:

- Niemals blind auf Links klicken, die in KI Antworten auftauchen. Schauen Sie sich vorher die Zieladresse genau an.

- Bleiben Sie skeptisch, auch wenn die Antwort von einem offiziellen Bot kommt.

- Halten Sie Ihre Systeme aktuell und nutzen Sie aktuelle Sicherheitssoftware.

- Aktivieren Sie Zwei Faktor Authentifizierung und verwenden Sie einen Passwortmanager für Ihre Zugangsdaten.

- Im Zweifel lieber zur Originalquelle. Verlassen Sie sich nicht nur auf automatisch generierte Texte.

- Sich weiterbilden. Bleiben Sie über aktuelle Bedrohungen informiert.

KI ist mächtig, keine Frage. Aber sie ist eben auch anfällig für Manipulation. Wer sich schützen will, muss lernen, auch smarten Systemen mit gesundem Menschenverstand zu begegnen. „Grokking" könnte nur der Anfang einer neuen Welle von Social Engineering Angriffen sein. Umso wichtiger, jetzt schon wachsam zu bleiben.