La Inteligencia Artificial se define como la simulación de la inteligencia humana realizada por máquinas con capacidad de tomar decisiones y resolver problemas sin la necesidad de la intervención de una persona.

A pesar de que el concepto fue introducido el siglo pasado, en la última década tomó impulso gracias al poder computacional para el tratamiento y la recopilación de los datos que permitió tecnologías más asequibles, económicas y rápidas para cualquier tipo de usuario.

¿Qué es la inteligencia artificial generativa?

Los modelos tradicionales de Inteligencia Artificial se basan en modelos estadísticos que se centran en reconocer patrones a partir de datos existentes y son más aprovechados para contextos analíticos y predictivos.

En el auge de la inteligencia artificial, se creó una nueva categoría llamada generativa que tiene el potencial de (re)construir o (re)producir contenido proveniente de algún texto, imagen, video, audio o código fuente, tan verosímil como el usuario lo permita.

Los modelos generativos, entonces, pueden producir nuevos datos (artificiales) usando datos reales (alimentados por el usuario) y crear información nueva; aquel horizonte que existía hasta hace un par de años solo en los libros de ciencia ficción o las películas va acercándose cada vez más a la realidad.

El motor en el cual se centran estos modelos generativos para su correcto funcionamiento es la técnica de Redes Generativas Adversarias (GAN, por sus siglas en inglés). Los GAN son parte del Deep Learning —rama del Machine Learning que simula el comportamiento de las neuronas y mejora la automatización y optimización de tareas analíticas y creativas sin la interacción humana.

Si bien el futuro es prometedor para cada uno de los campos dónde puede ser aplicada, y con grandes expectativas, existen riesgos vinculados a la adopción de esta nueva tendencia.

Cuáles son los riesgos de la Inteligencias Artificial Generativa

La IA Generativa reside en el ciberespacio y, por consecuencia, existen riesgos asociados que pueden afectar tantos a personas como empresas o gobiernos, en ESET identificamos principalmente 5 y las abordaremos a continuación:

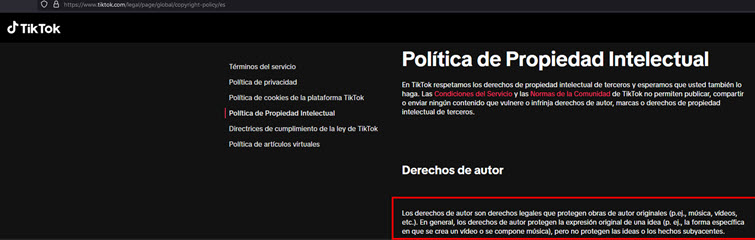

1.Moderación de contenidos

Algunas de las redes sociales, sitios web o aplicaciones no son legalmente responsables, o son muy ambiguos, en lo que refiere a los contenidos subidos por sus usuarios, como ideas o publicaciones hechas por terceros o subyacentes, ni el contenido generado por IA: aun cuando cuentan con términos de uso, normas de comunidad y políticas de privacidad que protejan los derechos de autor, hay un vacío legal que sirve de blindaje para los proveedores ante una violación de derechos de autor.

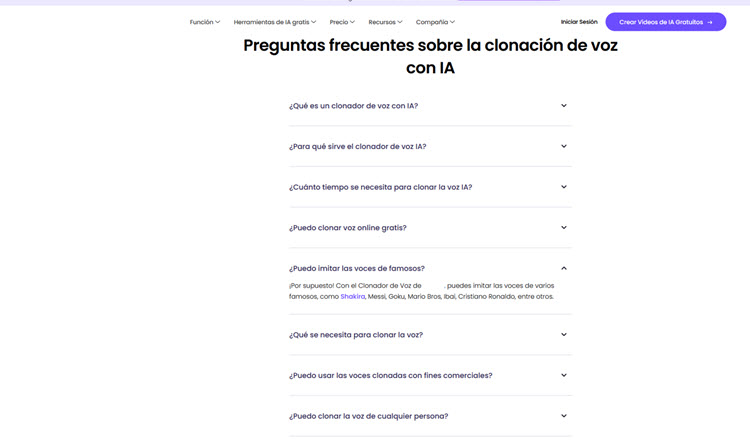

El usuario cuenta con un fácil acceso y una enorme disponibilidad de herramientas de IA Generativa que son poco claras, incluso contradictorias, en sus políticas de uso e implementación.

Sitio web que se encarga de clonar la voz: Sin restricciones de usar la voz de cualquier celebridad

Las preguntas aquí serían ¿la responsabilidad recaería en los dueños de estas plataformas/aplicaciones de IA Generativa, o se transfiere a los usuarios que usan el contenido derivado de estas para subirlo a cada una de sus redes sociales? ¿Las redes sociales tienen que empezar implementar aspectos legales que no recaigan en lo ambiguo para este tipo de contenidos?

2. Infracción de los derechos de autor e imagen

En los Estados Unidos, en mayo 2023, una nueva Huelga del Sindicato de Guionistas, comenzó una serie de conflictos al que se le unieron en julio del mismo año el Sindicato de Actores en Hollywood. Las principales causas de este movimiento se debieron a la petición de un aumento salarial derivado del auge de las plataformas digitales, ya que hubo un incremento en la demanda/creación del contenido y buscaban que las ganancias fueran repartidas proporcionalmente entre guionistas/actores y las grandes compañías.

Otro motivo fue el abuso de la IA Generativa por parte de estas compañías para producir contenido sin el consentimiento del actor o actriz de usar su rostro y voz para fines comerciales, por lo que solicitaron un nuevo contrato que los protegiera de la explotación de su identidad y talento sin su consentimiento ni remuneración para esta tecnología.

La originalidad de algún contenido independientemente de la fuente, con la llegada de la IA Generativa cada vez parece ser más difusa. En este caso, muchos derechos de autor y permisos de imagen fueron ignorados por grandes compañías, generando una enorme molestia y como consecuencia de esto Estados Unidos optó por implementar recursos legales que protegieran a ambas partes.

3. Privacidad

Retomando lo sucedido en Estados Unidos con los actores y guionistas, para que los modelos de IA Generativa puedan funcionar correctamente necesitan de grandes volúmenes de datos para ser entrenados, pero ¿qué sucede cuando este volumen puede obtenerse de cualquier fuente pública como videos, audios, imágenes, textos o códigos fuente sin el consentimiento del titular?

Es aquí donde las plataformas, aplicaciones y redes sociales debieran apegarse al marco normativo sobre la privacidad de datos de cada país en caso de existir, de lo contrario apoyarse Reglamento General de Protección de Datos (GDPR) del Parlamento Europeo que ya incluye una sección para la IA.

4. Cuestiones éticas

Aquellos países donde las regulaciones en materia de IA son escasas o nulas, son aprovechadas por algunos usuarios para fines nada éticos, estos van desde la suplantación de identidad (voz, imagen o video) para crear perfiles falsos que usan para cometer fraude/extorsión a través de alguna plataforma, aplicación o red social, como también lanzar campañas de phishing muy sofisticadas o estafas del tipo catfishing.

5. Desinformación

Aprovechando este tipo de IA las prácticas de difusión de noticias falsas en plataformas y redes sociales se ven mejoradas. La viralización de estos contenidos engañosos generados llega a perjudicar la imagen de alguna persona, comunidad, país, gobierno o empresa.

La inteligencia artificial generativa y los desafíos en los sectores industriales

En una encuesta realizada en 2023 por KPMG mostró que muchas de las industrias estiman que la implementación de la Inteligencia Artificial Generativa ofrece beneficios y oportunidades interesantes, como aumentar sus ingresos, el posicionamiento y la participación del mercado. El 77% considera que la Inteligencia Artificial Generativa tendrá un gran impacto en su negocio en los próximos 3 a 5 años.

Por otro lado, las industrias encuestadas que más han adoptado esta tecnología son la de Tecnología y Operaciones con un 56%, seguido de marketing (42%), ventas (40%), desarrollo del producto (40%). Mientras que las últimas en incorporarla fueron aquellas que involucran a Recursos Humanos (16%), Riesgos y Legales (14%).

¿Qué es lo que limita la implementación de esta tecnología para los sectores?

Independientemente del sector, la encuesta de KPMG indicó que las barreras que las industrias encuentran para la adopción de la IA Generativa son:

- Ausencia de talento calificado para desarrollar e implementar correctamente una IA Generativa (13%)

- Costo/falta de inversión (13%)

- Falta de un caso de negocio claro (13%)

- Poca de claridad sobre formas específicas de implementar la IA Generativa (12%)

- Falta de comprensión y/o estrategia del liderazgo en la adopción de nuevas IA Generativas (11%)

- Identificación de modelos de IA Generativa apropiados para el sector en el que se implementará (8%)

- Riesgos potenciales y/o amenazas a la privacidad de los datos que alimentan a la IA Generativa (8%)

- Infraestructura tecnológica insuficiente para soportarla (7%)

- Incapacidad para acceder/aprovechar los datos (6%)

- Resistencia cultural interna (6%)

- Exposición legal (3%)

- Incapacidad para realizar ciertas tareas simples y proporcionar resultados auténticos y precisos como lo requiera el negocio (2%)

Conclusiones

La IA Generativa presenta riesgos particulares que deben abordarse de manera cuidadosa para garantizar su uso ético y seguro. Estos riesgos incluyen como se describieron van desde la moderación del contenido que suben los usuarios, hasta aquel engañoso, sesgado o perjudicial para evitar la manipulación de información. Al considerar estos riesgos, es esencial implementar estrategias preventivas y correctivas, tales como:

- Filtrado y moderación efectiva: Desarrollar sistemas de filtrado y moderación robustos que puedan identificar y eliminar contenido inapropiado, engañoso o sesgado generado por modelos de IA Generativa. Esto ayudará a mantener la integridad de la información y a prevenir posibles consecuencias negativas.

- Entrenamiento con datos éticos y diversificados: Garantizar que los modelos de IA Generativa se entrenen con conjuntos de datos éticos, imparciales y representativos. La diversificación de los datos contribuye a reducir sesgos y a mejorar la capacidad del modelo para generar contenido más equitativo y preciso.

- Transparencia en la regulación del contenido: Establecer regulaciones que permitan a los usuarios comprender cómo se genera el contenido, el tratamiento que reciben los datos y las implicaciones que puede llegar a tener en caso de no cumplir.

- Evaluación continua de la ética y la calidad: Implementar mecanismos de evaluación continua para monitorear la ética y la calidad del contenido generado. Estos mecanismos pueden incluir auditorías regulares, pruebas de robustez y colaboración con la comunidad para identificar y abordar posibles problemas éticos.

- Educación y conciencia pública: Promover la educación y la conciencia pública sobre los riesgos asociados con la IA Generativa. Fomentar la comprensión de cómo funcionan estos modelos y cuáles son sus posibles impactos le podrán permitir al usuario participar activamente en la discusión y en la exigencia de prácticas éticas por parte de los desarrolladores y empresas.